¿Qué es IA explicable?

La Inteligencia Artificial (IA) ya forma parte de casi todos los aspectos de la vida moderna, desde asistentes virtuales hasta automóviles autónomos. Sin embargo, a medida que los sistemas de IA se vuelven más complejos, surge un problema importante: la opacidad de estos modelos. Esta falta de transparencia plantea grandes desafíos, especialmente en aplicaciones críticas para la seguridad, donde están en juego vidas humanas. Como ingenieros, es fundamental entender cómo estos modelos toman decisiones y asegurar su fiabilidad. Aquí es donde entra en juego la IA Explicable (XAI, por sus siglas en inglés): un conjunto de herramientas y técnicas diseñadas para aclarar el funcionamiento interno de los modelos de IA y proporcionar información sobre sus procesos de toma de decisiones.

Evolución de los modelos de IA

¿Para qué una IA explicable? Los modelos no siempre fueron tan complejos. De hecho, comencemos con un ejemplo simple de un termostato en invierno. El modelo basado en reglas es el siguiente:

- Encender la calefacción si la temperatura es inferior a 65 grados.

- Apagar la calefacción si la temperatura es superior a 68 grados.

¿Cómo saber si está funcionando el termostato? Las variables son la temperatura actual de la habitación y si la calefacción está funcionando, por lo que es muy fácil verificarlo en función de la temperatura en la sala.

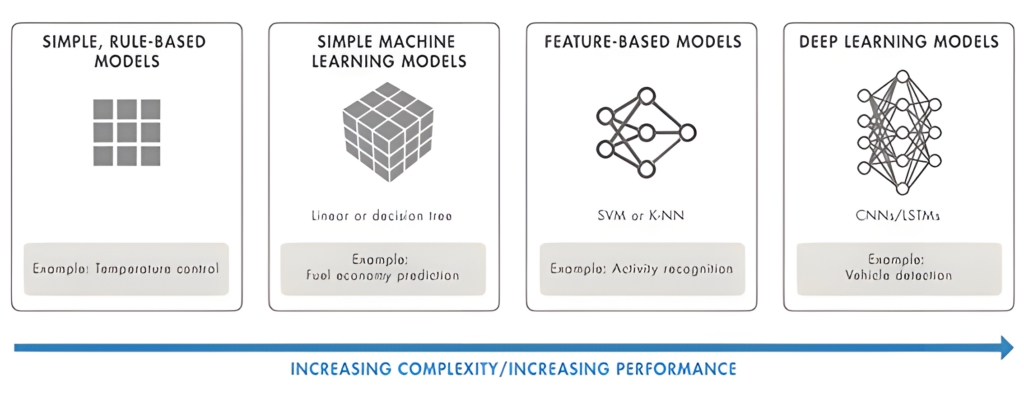

Algunos modelos, como el control de temperatura, son intrínsecamente explicables debido a la simplicidad del problema o a una comprensión «de sentido común» de las relaciones físicas. En general, para aplicaciones donde los modelos de caja negra no son aceptables, el uso de modelos simples que son inherentemente explicables puede ser válido si son lo suficientemente precisos.

Sin embargo, pasar a modelos más avanzados tiene ventajas:

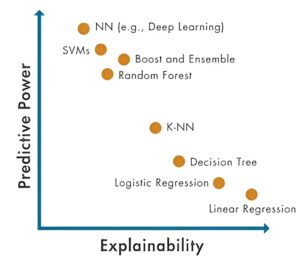

Figura 1: Evolución de los modelos de IA. Un modelo simple puede ser más transparente, mientras que un modelo más sofisticado puede mejorar el desempeño.

- Precisión: En muchos escenarios, los modelos complejos ofrecen resultados más precisos. A veces, estas mejoras no son inmediatamente obvias, pero pueden llevar a predicciones más rápidas. Por ejemplo, en la predicción del clima, los modelos avanzados de IA pueden analizar grandes cantidades de datos meteorológicos para prever condiciones climáticas severas con mayor precisión y acelerar la modelación climática. [https://www.nature.com/articles/d41586-024-00780-8]

- Trabajar con datos más sofisticados: Los ingenieros pueden necesitar trabajar con datos complejos como señales en tiempo real e imágenes, que se pueden utilizar directamente en los modelos de IA, ahorrando mucho tiempo en la construcción de modelos. Por ejemplo, los sistemas autónomos, que a menudo requieren la integración de datos de varios sensores y fuentes, como Lidar, radar, cámaras y GPS. Los modelos avanzados de IA pueden procesar e integrar de manera eficiente estos flujos de datos diversos en un sistema unificado. [https://la.mathworks.com/videos/driving-into-the-future-ai-enabled-autonomous-systems-1692363968391.html]

- Espacios de aplicaciones complejas: A medida que la complejidad de las aplicaciones sigue evolucionando, los investigadores exploran cómo las técnicas de aprendizaje profundo pueden optimizar procesos que antes dependían de métodos tradicionales como la extracción de características. Un ejemplo es el procesamiento de lenguaje natural. Aquí, los modelos avanzados de IA han logrado avances significativos, aprendiendo y extrayendo características relevantes de datos de texto crudo de manera autónoma. Este avance permite que aplicaciones como la traducción de idiomas en tiempo real y los asistentes virtuales inteligentes funcionen con una eficiencia y precisión sin precedentes.

Ahora, aunque hay muchos aspectos positivos al pasar a modelos más complejos, la capacidad de entender lo que está ocurriendo dentro del modelo se vuelve cada vez más desafiante. Por lo tanto, entender el papel de la explicabilidad se vuelve relevante para los ingenieros.

Entendiendo la explicabilidad: Lecciones de la clase de matemáticas

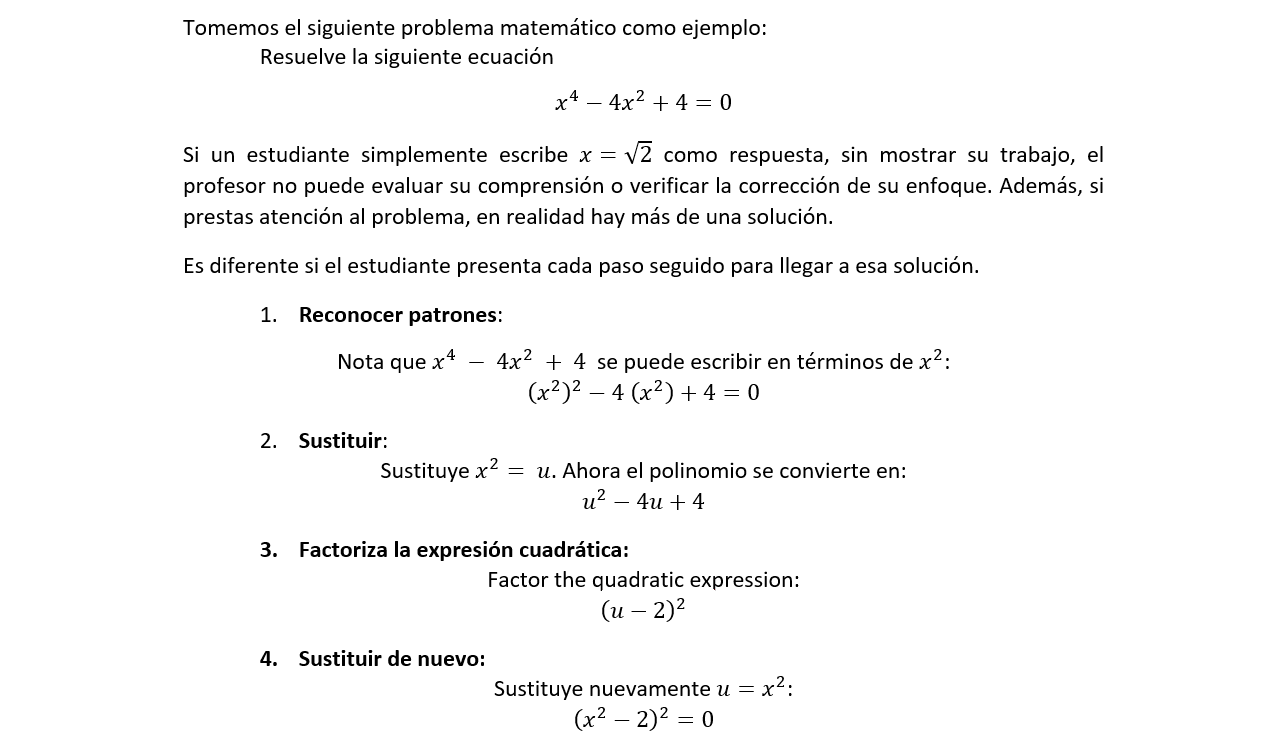

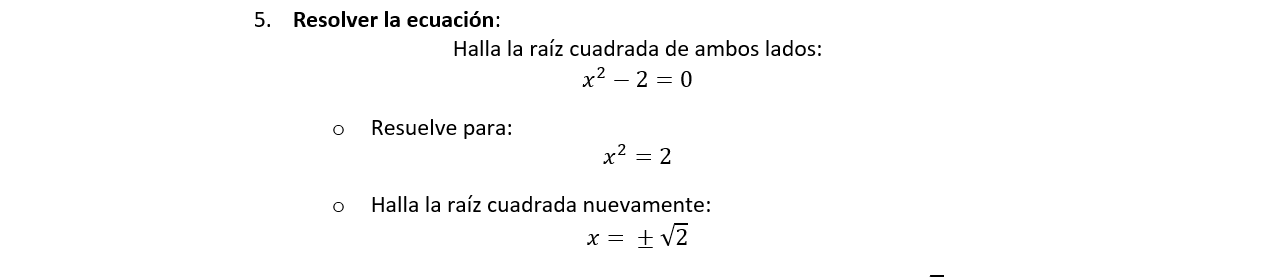

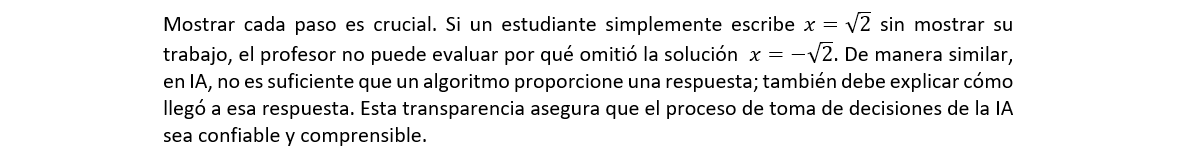

Evaluemos el papel de la explicabilidad con una situación común que muchos pueden haber visto.

¿Recuerdas la clase de álgebra? Ahí, a menudo se les pide a los estudiantes no solo que resuelvan problemas matemáticos, sino que muestren todo el proceso que los llevó a la solución. Esta práctica es crucial para los profesores porque les permite entender el proceso de pensamiento del estudiante, identificar cualquier error y asegurar que la solución sea correcta. De manera similar, en el ámbito de la inteligencia artificial, la explicabilidad juega un papel vital para generar confianza y entendimiento entre los sistemas de IA, desarrolladores, y usuarios.

¿Quién debería buscar la explicabilidad?

Los ingenieros deben implementar nuevos enfoques para asegurarse de que pueden mantener la confianza en sus sistemas a medida que usan modelos con mayor poder predictivo. El uso de modelos explicables puede proporcionar más información sin agregar pasos adicionales al proceso.

Actualmente, los ingenieros que necesitan más información sobre sus datos y modelos están incursionando en la explicabilidad para:

- Requisitos regulatorios: Existe un deseo creciente de utilizar modelos de IA en aplicaciones críticas para la seguridad, la gobernanza y el cumplimiento normativo que pueden tener requisitos regulatorios internos y externos. Aunque cada industria tendrá requisitos específicos, proporcionar evidencia de la solidez del entrenamiento, la equidad y la confianza puede ser importante.

- Identificación de sesgos: Los sesgos pueden introducirse cuando los modelos se entrenan con datos desbalanceados. Los sesgos son especialmente preocupantes para los modelos aplicados a personas. Es importante que los desarrolladores de modelos entiendan cómo los sesgos pueden influir en los resultados de manera implícita, y que los tengan en cuenta para que los modelos de IA «generalicen» —es decir, que proporcionen predicciones precisas sin favorecer de manera implícita a grupos o subconjuntos.

- Depuración de modelos: Para los ingenieros que trabajan en modelos, la explicabilidad puede ayudar a analizar predicciones incorrectas del modelo. Esto puede incluir analizar problemas dentro del modelo o los datos.